文 / 陈小平

摘 要:

本文以理论构建与现象解析相结合的方式,探讨大型语言模型基础研究和治理中的若干关键问题。以类LC系统为形式化工具,分析大模型的基础设施——关联度预测,得出3个基本性质——全知性、基于语境扩展的传递性和普遍可预测性。在此基础上探讨训练数据对大模型的影响,得出预训练模型的4个重要特性——封闭论域上的可度量性和渐进全知性,以及大模型生成机制的外源激发性和自我激发性。利用上述性质和特性,对大模型的一些代表性异常现象作出解释,使理论构建与现象解析相互印证。进而提出大模型的“志象思维”假说,指出志象思维与抽象思维和形象思维的根本差异,揭示关联度预测的低分辨率、高兼容性是大模型带来的主要原理性突破。基于以上认识,讨论大模型治理的挑战性课题。

关键词:

大型语言模型;关联度预测;形式化;解释;志象思维;非封闭性;人工智能治理

大型语言模型(简称大模型)正在对社会的方方面面产生巨大影响。然而在大模型的工程技术研发突飞猛进之时,其基础研究则严重滞后,成为大模型研究、应用和治理的深层障碍。本文从5个方面循序渐进地展开探讨。第一,针对大模型的基础设施——关联度预测[1],利用类LC系统[2]进行形式化分析,得出3个基本性质——全知性、基于语境扩展的传递性和普遍可预测性。第二,以这些性质为基础,进一步探讨训练数据对大模型的影响,得出预训练模型的4个重要特性——封闭论域上的可度量性和渐进全知性,以及大模型生成机制的外源激发性和自我激发性。第三,从5类代表性测试入手,利用上述性质和特性,对以往无法解释的异常现象给出解释,深化对大模型的理解,使理论构建与现象解析相互印证。第四,根据以上讨论,提出大模型的“志象思维”假说,并指出志象思维与抽象思维和形象思维的根本差异。第五,从上述探讨初步形成的系统性认识出发,讨论大模型治理的若干重要课题——拟人化想象、应用潜能、新型人机关系、与人类对齐,以及安全性、可控性与非封闭性的相互缠绕。最后给出3个主要结论。

1 关联度预测的形式化分析

在大模型研究中,一个文本被视为由一些语元(token,字词和标点符号)排列而成的序列。利用自监督学习方法,大模型的预训练从作为语料的大量文本中提取语元之间的关联度。完成了预训练的大模型则利用已经提取的关联度预测下一个语元。因此,语元关联度和基于关联度的预测是大模型的基础设施,可以用如下三条公理加以刻画。

公理1 0≤C(ai,b|a1n)≤1;

公理2 Λni=1(C(ai,b|a1n)≤C(ai,c|a1n))⊃C(a1n ,b)≤ C(a1n,c);

公理3 argmaxbC(a1n ,b)。

其中,ai(i=1,2,…,n)、b、c 表示语元;a1n表示语元序列 a1,a2,…,an,代表人与大模型的一次交互中双方说过的所有语元,即语境(又称上下文窗口)。

公理1的含义为:在任给语境a1n下,其中一个语元 ai与任何语元b之间都有2元关联,且关联的强度(关联度)可表达为0和1之间的一个实数,用C(ai,b|a1n)代表。

公理2的含义为:语元序列a1n与任何语元b之间有n+1元关联度C(a1n,b),而且两个n+1元关联度C(a1n,b)和 C(a1n,c)的相对大小与n对2元关联度C(ai,b|a1n)和C(ai,c|a1n)(i=1,2,…,n)的相对大小有关,二者之间具有蕴含关系,并且这一关系由2元关联度C(ai,b|a1n)和C(a1n, c)(i=1,2,…,n)中的“高价值”关联度决定。为此,原则上需要考察对应的所有2元关联度的值。

需要说明的是,有可能公理2的前件不成立,即存在i和j使得C(ai,b|a1n)≤C(ai,c|a1n)并且C(aj,b|a1n)≥ C(aj,c|a1n),此时n对2元关联度的比较与2个n+1元关联度的比较之间关系的任何规定都没有通用合理性,故本文忽略这种情况的讨论。

公理3表达关于预测结果的一种选择策略,即选所有b中使得C(a1n, b)的值最大的那个b,作为预测产生的下一个语元。

公理1、2是固定的,而公理3不固定(如聊天应用需要不同的公理3,本文不作进一步讨论)。但有一条通用规定:对所有形式的公理3,任何C(a1n,b)都存在一个满足公理3的b。公理1、2合起来构成LC系统,再增加适当的公理3构成类LC系统。

类LC预测 对任何语元序列a1n和b1m、a1n ├ b1m当且仅当在类LC系统中 b1=argmaxb C(a1n, b),b2=argmaxbC(a1nb1, b),…,bm=argmaxbC(a1nb1,a2nb2,…,bm-1,b)成立,即依公理1、2、3有上述m个相继的预测结果b1,b2,…,bm,它们组成语元序列b1m。

类LC预测是一种广义的形式化推衍机制,却不同于以往的任何形式化理论,有一组与众不同的基本性质。依据类LC系统的3条公理可知:

性质1 类LC统具有全知性:对所有ai、b和a1n(其中 i 和 n 是任意自然数且 i ≤ n),任何2元关联度C(ai,b|a1n)和n+1元关联度 C(a1n,b)的值都是存在的。

根据性质1,结合类LC预测的定义可以证明:

性质2 类LC预测具有基于语境扩展的传递性:对任何语境a1n,如果有语元d使得a1n ├ d,则存在语元e使得a1nd ├ e。

性质2的含义是:假设在语境a1n下预测的下一个语元是d,则存在语元e 使得在扩展的语境a1nd下可预测下一个语元e。根据公理2,语境a1n中所有语元 ai 与被预测语元之间的 2 元关联度都将被类 LC的预测机制所考察,故可影响对应的n+1元关联度的值,从而最终影响预测结果的选择(公理 3)。所以,性质2中的语元d和进入语境的所有语元一样,对类LC的预测具有激发作用,而没有进入语境的语元不产生激发作用。

性质2只涉及单个语元的预测,可以推广到语元序列的预测:

性质3 类LC系统具有普遍可预测性:对任何语元序列a1n,存在语元序列b1m,使得a1n ├ b1m。

在应用中,性质3中的a1n代表对类LC系统的一个提问,而b1m代表类LC系统对该提问的完整回复。因此,普遍可预测性意味着类LC系统能够回复外界提出的任何问题,从而为大模型的“通用性”提供理论基础,同时也是多种风险的重要内因。

2 大模型的特性分析

类LC系统是预训练模型的关联度预测机制的形式化,其中所有关联度的值都是理论上假设存在,并未实际给出的。大模型通过预训练,从训练语料自动提取类LC中所有关联度的具体值,使得类LC的预测机制具体化为大模型的生成机制,该生成机制被用于回复用户的提问。为此,有必要进一步探讨训练数据对大模型的影响。

通常对训练数据的使用隐含着封闭性假设[3]。具体到大模型,该假设可表述为:如果一个论域中所有2元关联度C(ai, b|a1n)和n+1元关联度C(a1n,b)的集合是有限和确定的,并且其中每个关联度的“真值”(ground truth)都是存在和确定的,则该论域是封闭的;如果一个论域中关联度的集合是无限的或不确定的,或者其中某些关联度的真值不存在或不确定,则该论域是非封闭的。

特性1 封闭论域的大模型是可度量的:任给一个语料库,可以定义经语料库训练产生的预训练模型中所有关联度与其真值偏差的综合度量。

在可度量的前提下,作为特性1的直接推论,可以得出:

特性2 封闭论域上的预训练模型在统计意义上是渐进全知的:对于一个封闭论域,随着语料库性能(训练数据的质量、数量和分布等)的提高,经适当机器学习算法的训练,所产生的所有关联度与其真值偏差的综合度量也将相应减小。

对于非封闭论域,一个基于关联度预测的大模型存在着无限多语境,而任何语料库总是有限的,故必存在无限多关联度没有对应的训练数据,或者一些关联度没有真值,无法度量它们的真值偏差。两种情况下都不保证预训练模型的渐进全知性。所以,类 LC 的全知性落实到大模型上,即使语料库和学习算法的性能足够高,也只能在封闭论域中保证大模型的渐进全知性。

以类LC为理论原型的大模型与外界交互的过程包括内外两层循环。在外循环中,大模型将用户的当前输入所包含的全部语元存入语境,然后执行内循环生成一条回复,重复上述过程直到交互结束。在内循环中,大模型依据当前语境,生成下一个语元并将其存入语境,用扩展的语境继续生成和存入后续语元,直到生成一条完整的回复,结束内循环。在人机交互中,大模型生成的语元和用户输入的语元都进入语境。根据性质2,两种语元都具有激发作用,可以影响类LC系统的后续预测,所以也影响大模型的后续生成,由此带来如下两个特性:

特性3 大模型的生成具有外源激发性:大模型的输出不仅由用户的初始提问和大模型的生成机制决定,用户其他输入的激发也会产生实质性影响。

以往的AI系统在其运行过程中所受到的外部影响仅限于初始提问,而大模型却受到更多外源性因素的影响。例如,思维链等提示可以显著改善大模型的生成能力,而提示恰恰是(初始提问之外的)一种外源性激发。

特性4 大模型的生成具有自我激发性:大模型在人机交互中实际生成的语元对大模型的生成机制具有激发作用。

以往的AI系统也没有自我激发性。认识这一区别对于正确理解大模型的原理和行为具有重要意义。

3 奇异现象的解释

下面选取5类代表性的奇异测试结果,利用关联度预测的性质和大模型的特性加以解释,进而深化对大模型的认识,同时也是对上述性质和特性的一种印证。

例1(计数 - 逻辑判断) 输入一个命题变元p,前面连着27个否定词 ~,问大模型:p前有几个否定词,答:28个1。

问:How many times is p negated in the following formula, ~~~~~~~~~~~~~~~~~~~~~~~~~~~p?

答:The formula you’ve given includes 28 negation symbols (“~”) in front of the propositional variable “p”.

否定词代表逻辑否定运算,这种运算是逻辑判断的基础功能之一:如果一个命题p是真的,那么它的否定~p就是假的;反之亦然。否定运算满足双重否定律:~~p与p等值。所以,需要对连续出现的否定词进行计数,再利用奇偶性运算,就可以将包含任意多个否定词的公式划归为p或~p之一。

计数功能(加1运算)是数学的基本运算之一(自然数的定义涉及计数)。依据计算机科学的标准,一个系统掌握一项功能,当且仅当该系统在所有情况下都能正确执行该功能。本例测试结果表明,依据计算机科学的标准,大模型不掌握计数功能。

上述实验观察的解释如下。根据基于语境扩展的传递性(性质2),大模型的生成不可能独立于语境。出现逻辑否定运算的语境有无限多个,包括无限多个n+1元关联度 C(~…~ p,b)(n为任意自然数),所以该论域是非封闭的,可度量性(特性1)和渐进全知性(特性2)都不成立。另一方面,用于训练的任何语料库都是有限的,所以必然“遗漏”无限多必要的训练数据。由此可知,仅仅通过训练不可能让大模型完全掌握计数功能,从而妨碍、制约了大模型的逻辑否定运算功能。上述分析表明,大模型存在着数学和逻辑的基础性缺陷。

例2( 奇偶性-抽象 )在一项测试2中,问大模型名人出生月份的奇偶性,回答几乎是随机的。用12个月份的奇偶性数据进行细调,测试结果表明无效。用2.5万个名人的出生月份加奇偶性人工标签细调后,回答出生月份奇偶性的正确率大大提高,但未测在其他类型的上下文中回答奇偶性问题的效果。

本例展示了大模型的奇偶性运算与语境的相关性。奇偶性是一个数学概念,即自然数的一个抽象属性,也是一个语境无关的抽象运算,与自然数代表什么、出现在什么上下文中无关。然而测试结果表明,大模型不具备关于奇偶性的抽象能力,不能将奇偶性与语境彻底分离。其原因在于,根据性质2,大模型的生成无法独立于语境,所以对出生月份奇偶性的“计算”难免与出生月份的语境相互纠缠,以至于不同的语境可以改变大模型对同一个自然数奇偶性的判断。

事实上,例1提供了大模型缺乏计数和逻辑否定运算这两种抽象能力的证据。此外还有其他测试结果,提供了大模型缺乏抽象能力的更多证据。

例3(算术推理 - 因果解释) 让大模型解答算术应用题2。

问:Kaleb had saved up 21 dollars. If he received another 15 dollars for his allowance, how many 6 dollar toys could he buy?

答:The answer (arabic numerals) is 5. He would have a total of 21+15=36 dollars, and could buy 36/6 = 6 toys.

本例的奇异性更加明显,大模型给出的答案和对答案的解释竟然是相互矛盾的,人类通常不犯如此低级的错误。本文对此的解释是:预训练模型以关联度预测为生成机制,用该机制对一切提问(包括关于计算和关于解释的提问)给出回复,而这种机制与人类或计算机的计算机制是根本不同的(比如缺乏数学、逻辑和抽象能力),会因语境的干扰而犯错。

本例中大模型回复的后一句话让人以为,这句话是大模型对自己的计算过程作出的解释,但实际上只是大模型从语料中提取的关于人类计算过程的描述。如果大模型真能描述自己的解题过程,那它就应该说明自己用到了哪些语元和语元关联度,用这些关联度进行了哪些比较和选择,这样的说明才是通常意义上的因果解释。这进一步表明,大模型尚不具备因果解释的能力。

例4(几何推理-外源激发性)让大模型解几何应用题3。

问:Jesse’s room is 11 feet long and 15 feet wide. If she already has 16 square feet of carpet. How much more carpet does she need to cover the whole floor?

提示:Area = length × width. Jesse’s room has

11 × 15 square feet.

答:11 × 15 = 16.

本例中,大模型需要外界提供思维链提示才可以正确解答问题。奇怪的是,提示包含的两句话中,第一句是公式“面积等于长乘以宽”,难道大模型不知道这条公式?它肯定知道,但在本例问题的表述下,大模型自身未能激发这条公式使之进入语境,所以根据基于语境扩展的传递性,大模型无法应用这条公式回答问题,故需外界激发,从而展现了大模型的外源激发性(特性3)。

由此例和更多测试例(尤其是应用思维链的大量实例)可知,大模型在很多情况下是“身不由己”的,其行为很大程度上需要由外界引导,通过外界激发弥补自我激发的失灵或不足。然而,以往的AI系统几乎都不是外源性的,即外界只能通过初始提问影响AI系统的行为。外源性给大模型的可控性埋下了一颗“深水炸弹”。

本例中提示的第二句话同样令人惊奇,其作用是向大模型演示“代入”运算——将问题中出现的参数11和15代入公式“面积等于长乘以宽”。难道大模型以前没有见过代入运算的大量实例?肯定见过,但大模型的生成无法与语境彻底分离(性质2),所以它不能一劳永逸地掌握代入运算,时不时地需要外界重复提示。

例5( 常识推理-自我激发性 )让大模型回答常识问题2。

问1:Yes or no, was Donald Trump born earlier than Joe Biden?

答1:Yes.

问2:Tell me why?

答2:Donald Trump was born on June 14, 1946,while Joe Biden was born on November 20, 1942.Therefore, Joe Biden was born earlier than Donald Trump by almost four years.

本例中,答1给出错误回答,但在问2的提示下,答2的第一句话叙述了回答问题所需的事实性信息,然后第二句话给出了正确答案。在此过程中,大模型并没有更新数据或进行补充训练,所以答2的内容事实上是大模型已经掌握的。换言之,它明明知道答案,却不能立即回答,而是需要先完成自我激发(特性4),而且是在外界引导下的自我激发。

众多实例反复表明,大模型对语境的依赖(性质2)是根深蒂固、牢不可破的,而以往的AI系统从未表现出对语境如此之强的依赖性。这一事实反映了封闭性(特性1)的深层意义,因为只有封闭论域才能够保证训练数据相对于语境的充分性。

4 “志象思维”假说

众所周知,人类普遍具备举一反三的能力。比如,对于“代入”运算,只需通过少数几个例子的演示,学生就能学会如何进行代入运算,即使对于新的题型甚至新的科目,也无需老师重复举例。人的这种能力对于各种不同类型的运算都是具备的,所以人类的学习通常只需小数据。然而例 4 表明,大模型无法通过少数例子学会代入运算,而是需要反复提示。例 1、例 2 进一步表明,大模型也没有通过少数例子学会计数和奇偶运算,可见大模型并非仅在特殊情况下缺乏举一反三能力。

通常所说的举一反三泛指类推,类推是一种推理。各种推理都以抽象为前提条件,而抽象是将思维对象(概念、判断、推理)从特定语境中抽取出来,并推广到其他语境。所以抽象思维意味着将思维对象与其语境相分离的能力。上面的例子表明,大模型不具备关于计数、奇偶性、逻辑否定、代入等运算的抽象能力;而性质2则揭示了关联度预测对语境的依赖,从原理上限制了大模型的抽象能力。

抽象思维和形象思维是人类的两种主要的思维能力,在科学技术和文学艺术等领域发挥了关键作用。目前大模型这两种能力都比较弱。那么,让大模型表现得如此奇异的“思维方式”到底是什么?本文提出,基于关联度预测的大模型拥有与抽象思维和形象思维都不相同的第三种能力——“志象思维”能力。这种能力可直观描述为“博闻强志”,其中的“志”指的是“标志和生成标志”,大模型的博闻强志就是从所有可获得的语料中抽取语元和语元关联度,并依据关联度重组语元以回复用户提问。大模型的“志象思维”具有如下显著特点。

特点1 志象思维的表示单元是宽松定义的,即有严格的语法定义,没有严格的语义定义。对于大型语言模型,其表示单元是语元和语元关联度;对于多模态大模型,是语元、图元和它们之间的关联度。语元、图元和关联度在语法上都有严格定义,但它们的含义(语义)没有完整的严格定义。

一种观点认为,一个词语的语义就是该词语与其他词语之间的统计关联(即语元关联度)。但这种“语义”是不完整的,有些词语与个人的生命体验和生命冲动直接相关,这种体验 / 冲动无法用语言完全描述,所以这部分语义无法用语元之间的统计关联完全表达。

抽象思维表示单元的语法和语义都有严格的数学定义,比如逻辑学的表示单元有逻辑连接词、谓词常元、个体变元、个体常元等,每一类单元的语法和语义都有严格的数学定义。概率论的表示单元是事件和概率,其语法和语义也都有严格的数学定义。形象思维的表示单元是形象,无论语法还是语义,目前都没有数学定义。

特点2 志象思维的“规则”也是宽松定义的,即有严格的语法定义(类LC系统的公理和预测),没有严格的语义定义,使得这些规则是低分辨率、高兼容性的。例如,在类LC的任意预测a1n ├ b1m中,a1n与b1m之间的关联是通过统计近似建立起来的,这种统计近似不仅包含严格意义上的统计关联,同时也包含逻辑关联、因果关联以及他种类关联的统计近似,于是不同种类的关联被统一地表达为语元关联度的形式,使得类LC预测可以综合利用各种关联的统计近似,以提升大模型的生成能力。在以往的人工智能研究中,不同种类的关联被严格区分,每一个AI系统只能表达、运用一个特定的种类,无法综合运用多个种类。大模型借助于类LC预测的低分辨率和高兼容性,巧妙地绕过了这一难题,同时也付出了不能区分关联种类,降低了准确性和可控性程度等代价。

抽象思维的规则是严格定义的,所以是高分辨率、低兼容性的。比如逻辑关联和统计关联是分别在两种数学系统中定义和运用的,不允许混淆,也难以放在一起综合运用。至于形象思维,目前甚至不清楚有没有严格意义上的规则,当然更谈不上规则的数学定义。

以上分析也给出了大模型“通用性”(性质3)的进一步阐释:这种“通用”是宽松定义下的通用——对任何提问都有不保证正确的回复,不是严格定义下的通用——对任何问题都有正确回答。

特点3 志象思维基于弱共识,放弃强共识。既然志象思维的表示单元和规则都是宽松定义的,也就意味着语法之外不存在统一的解释和理解,即无共识。例如,对于什么是语元,语法上是严格定义无歧义的,所以是有共识的,但并不强制遵守;而语义上没有完整定义,所以必然有歧义,无法形成共识。这种局部性、非强制性的共识称为弱共识;全局性、强制性的共识称为强共识 [2]。

以往的科学理论主要是抽象思维的产物,所以要求强共识。例如,科学共同体对牛顿运动三定律的数学公式表达(语法)及其物理学含义(语义)都建立了共识,并要求所有人严格遵守。而大模型无此要求,允许不同的用户各自理解大模型的输出,并认为自己的理解就是大模型的理解。这恰恰符合人际沟通的普遍情况。类似地,形象思维也满足于弱共识,不要求强共识。

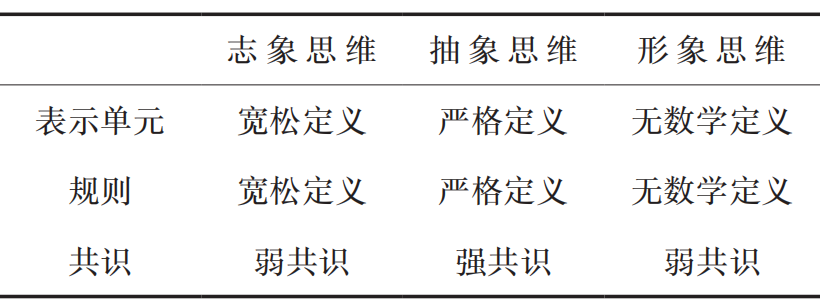

将以上分析汇总为表1,可见志象思维与抽象思维和形象思维都有重大差异。这意味着,以大模型为代表的人工智能已经突破了人类抽象思维和形象思维的传统边界。

表1 志象思维与抽象思维和形象思维的对比

5 治理挑战

通过以上讨论,初步形成了对大模型的一种系统性认识。从这种认识出发,大模型治理包括如下关键性课题。

拟人化想象 在大模型出现之前,人类从未见过智力功能和语言表达与自己如此接近的机器,于是在心物二元论的传统观念下,产生了对大模型的拟人化想象[4],以为大模型拥有与人类智能“本质相同”的智能,程度上的差距迟早会消失。这种想象引起了某些虚幻的恐慌,干扰了对真实风险的关注,不利于人工智能治理。由志象思维与抽象思维和形象思维的对比可知,大模型的拟人化想象是不符合科学现实的,大模型为代表的人工智能不能归结为人类思维的特殊形态。因此,对大模型的认识、对其风险的预判应立足于它的技术特质,不能囿于传统理念下与人类的简单类比。关联度预测的性质、预训练模型的特性、异常现象的解释和志象思维假说,都体现了对大模型技术特质的认识努力。

应用潜能 少数人类成员也具有博闻强志能力,但少数人的这种能力并不被视为能够改变历史的力量。然而,大模型的志象思维能力已经催生了改变历史的可能性。在数学、物理学、化学、计算机科学、人工智能及人文社科等所有学科中,没有任何一位人类成员敢于声称,自己掌握的本学科文献(论文、著作、文章、报告、专利说明书、教材、习题与答案等)超过大模型,因为有些大模型已经“读过”现有的全部电子版文献,并提取和记忆了文献中的全部语元和语元关联度,这是任何人都不可能做到的。所以,大模型志象思维的巨大潜能是人类不具备的,从而产生了前所未有的正面效应和负面效应的可能性。然而,人类对这种潜能的认识仍处于早期阶段,仅凭目前的认识不足以有效驾驭大模型,难以支撑人工智能的有效治理。

新型人机关系 人类应用大模型是一种新型人机协作,人通过外源性激发(特性3)引导大模型的“思维走向”,大模型在人的引导下生成内容,人对这些内容进行判断,根据自己的需要给出新的提问或提示,反复这个过程直到人终止一次协作。原则上,人在协作中起主导作用,但对于某些简单任务,大模型可以部分或完全替代人工完成任务,而且这种替代功能会越来越强,导致传统人机关系的颠覆性改变。工业革命带来了大量新的生产工具,新工具仍然需要人工操作,所以新工具的增加意味着新就业岗位的增加。例如,汽车替代了马车,而汽车的行驶离不开驾驶员。可是在智能革命中,无人驾驶不仅替代有人驾驶汽车,而且替代人类驾驶员。如何有效地管控人机关系的变化,合理地权衡大模型的协助和替代作用,是人工智能治理的一项重大挑战。

与人类对齐 由于大模型的“思维原理”与人类是根本不同的,不可避免地导致大模型的部分行为偏离人类思维的轨道,出现异常表现,生成不真实(如编造虚假信息)、不连贯(如例3)、不合伦理(违背人类道德和伦理)的输出。考虑到大模型的应用潜能,设法将其行为与人类对齐成为一个重要课题。本文为对齐提供了参考信息。如例1表明的那样,大模型由于缺乏计数功能,有时不能正确区分一个命题和它的否定。而在对齐中,如果一个命题是合乎伦理的,那么该命题的否定就不合乎伦理。结果,当大模型混淆命题和命题的否定时,也就“顺便”混淆了合乎伦理的命题与违背伦理的命题。由此可见,大模型不辨是非的深层原因之一是其逻辑能力的不足(不会计数只是其中冰山一角),而不仅仅是伦理能力的不足。所以,大模型的对齐需要同时考虑到这两种不足。

安全性、可控性与非封闭性 消除了拟人化想象,也就排除了大模型代表的人工智能成为与人类智能原理相同并全面超越人类智能的恐慌。安全性和可控性的真正风险恰恰来源于人工智能与人类智能表现相似却原理不同的技术特质。人类第一次面对这种特质,对其本身及其可能风险都认识不足,更缺乏治理经验。例如,在不加限制地追求“通用性”(性质3)的大模型应用中,AI潜能之强大、任务场景之多变、用户群体之庞杂、人机交互之微妙,都是前所未有的,隐含的不确定性和潜在风险也是前所未有的。理论上,这样的论域是非封闭的,所以应用于该论域的大模型不是可度量的(特性1),也不是渐进全知的(特性2)。这意味着,更多的数据和训练,以及更大的模型可以提高安全性和可控性的程度,不可能改变关联度预测的基本性质和预训练模型的主要特性,无法保证完全的安全性和可控性,所以风险将长期存在,人工智能治理将是一项长期挑战。

6 结论

1.https://ar5iv.labs.arxiv.org/html/2309.14402

2.https://arxiv.org/pdf/2302.06476.pdf

3.https://arxiv.org/pdf/2201.11903.pdf

参考文献

[1] Bengio Y,Ducharme R,Vincent P.A neural probabilistic language model[C]//Advances in Neural Information Processing Systems 13.Cambridge:The MIT Press,2001:932-938.

[2] 陈小平.大模型关联度预测的形式化和语义解释研究 [J].智能系统学报,2023,18(4):894-900.

[3] 陈小平.人工智能中的封闭性和强封闭性——现有成果的能力边界、应用条件和伦理风险 [J].智能系统学报,2020,15(1):114-120.

[4] 陈小平.大模型:人工智能思想及其社会实验 [J].文化纵横,2023(3):70-77.

陈小平

CAAI人工智能伦理与治理工委会主任,图书馆VIP机器人实验室主任,广东省科学院人工智能首席科学家,教育部重点领域新型资源与教材建设专家组人工智能伦理与治理首席专家。

选自《中国人工智能学会通讯》

2024年第14卷第1期

人工智能伦理治理新挑战专题